5.1、简介

集群服务中的节点ip不会永远不变,如果变化了怎么办?1台机器处理不过来,扩容了3台,如何让新增的3台快速投入使用,流量如何很快的流入新增的机器。集群中出现有问题的机器,如何下线呢?解决这些问题需要引入一个新的概念,服务发现

服务发现需要解决以下问题:

- 服务IP与端口的确定方式。

- 服务注册与发现。

- 服务下线

- 服务健康监测。

- 节点加入或退出,如何通知订阅者变化。

- 查看应用的订阅列表,发布列表,以及订阅节点。

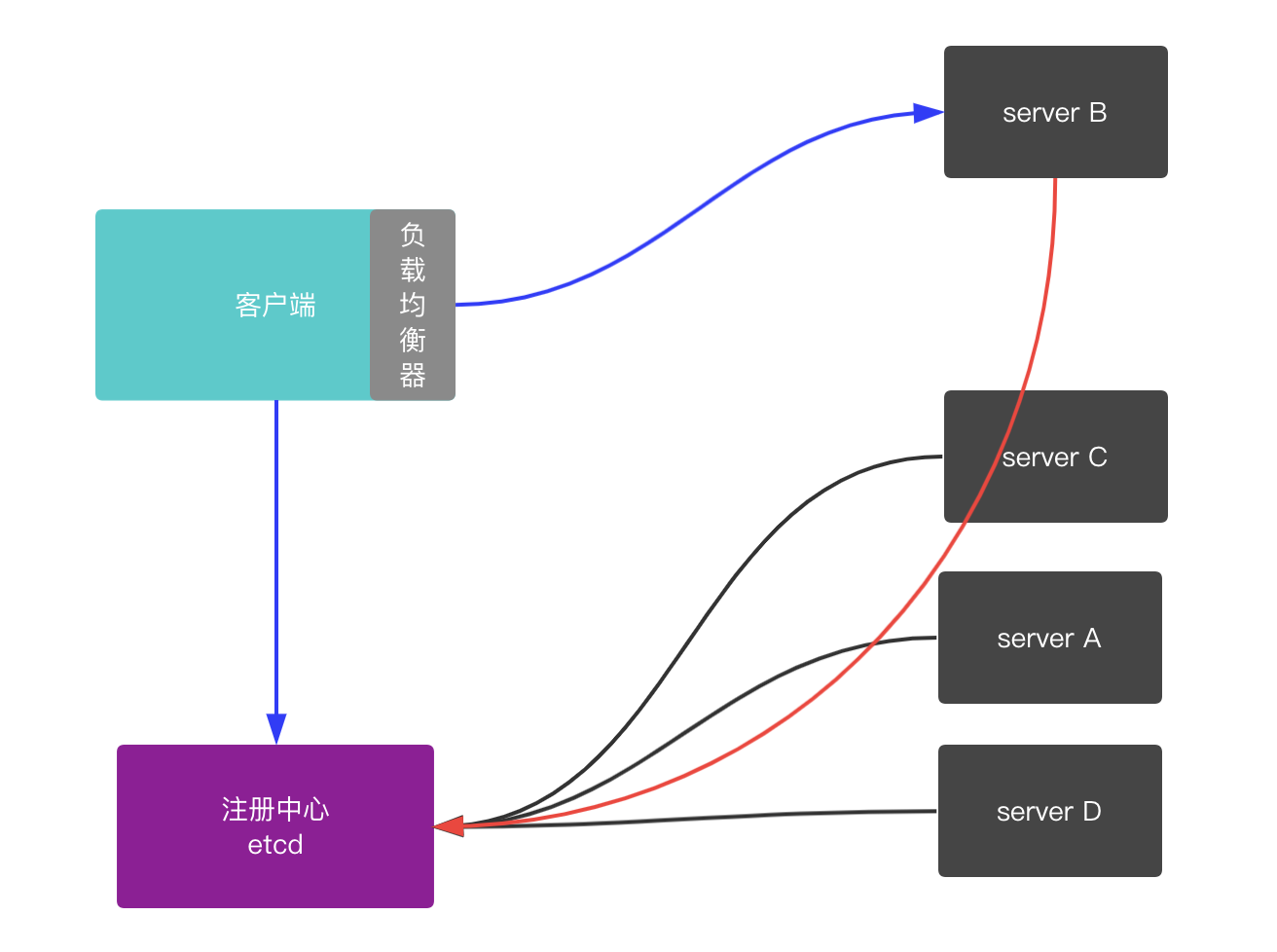

当A节点访问B集群的机器,这次访问究竟应该访问哪个节点?基于什么策略如何确定的?这又涉及到另一个概念,负载均衡,它是提供高可用服务的关键基础组件,核心作用就是将大量请求以合理的方式分配到多个执行单元上去执行,达到最优化的资源使用方式,避免多个单元同时发生过载。

比如我们从注册中心查询到10个可用节点,通过负载均衡器,可以将我们的10个请求,以一种策略打散到不同的可执行节点上,保障可用性。

关于基于etcd的服务发现与负载均衡算法可以先了解下。

5.2、实践

5.2.1、etcd安装

etcd下载地址:etcd

1 | cd etcd-v3.4.7-darwin-amd64 |

5.2.1、Load balancing

可以看下grpc关于负载均衡的demo

在负载均衡算法中介绍了两种负载均衡模式,客户端模式与服务端模式,gRPC官网推荐的是客户端模式,既进程内负载均衡。

客户端从注册中心拉取所有注册的服务,然后让问server B。

5.2.2、Builder

首先实现Builder接口,Builder的作用是创建一个解析器,该解析器将用于监听目标注册中心server节点的变化。

1 | type Builder interface { |

接着实现Resolver接口,Resolver监听目标节点的地址的变化更新。

1 | type Resolver interface { |

rpc请求的时候,会调用Builder获取Resolver解析器。那么我们在Builder中实现与etcd客户端的初始化,并且开启解析器根据servicename读取当前配置的ip:port。

实现ETCDResolverBuilder,这里连接etcd有个小坑,就是连接超时并不提示错误,只有真正执行指令的时候才会报错,这里需要通过cli.Status主动检查下连接状态。

1 | const ( |

5.2.3、Resolver

实现ETCDResolver解析器

1 | type ETCDResolver struct { |

5.2.4、服务注册

通过etcd客户端的put方法可以直接注册服务。更新NewGreeter方法

1 | package logic |

5.2.5、服务变更

服务变更是很常见的现象,比如服务下线,服务扩容上线更多新的节点。这些节点如何有效并且及时的同步到客户端呢?

etcd提供了watch的能力,watch的作用就是在新服务改变(重新注册,下线等)后, 告知各个服务执行相应的逻辑。所以只需要在解析器中使用watch方法,根据对应的变更来调用UpdateState更新客户端解析器维护的节点列表即可,实现如下:

5.2.5.1、新服务上线

通过etcd客户端的watch方法,收到通知后,如果是PUT操作,则做目标服务节点的更新。

1 | func (e *ETCDResolver) watch(serviceName string, addrList []resolver.Address) { |

5.2.5.2、服务下线

服务下线需要主动去注册中心注销自己的节点信息,并且我们把注册操作移到main函数中处理,注销实现如下:

1 | // 从etcd注销服务 |

main函数监听退出事件

1 | import ( |

服务正常下线,我们要主动告知客端,让客户端在自己维护的目标服务节点中把自己踢出掉。也是通过Watch,处理DELETE事件即可。

1 | func (e *ETCDResolver) watch(serviceName string, addrList []resolver.Address) { |

5.2.6、健康检查

正常情况下退出,我们可以主动通知etcd注销该下线的节点,但是在异常退出的情况下,可能没有执行注销操作。甚至是正常退出后,也发出了注销通知,但是因为网络环境的原因导致这个通知没有通知到etcd。这种情况下,客户端依然认为该节点可用,继续向该节点发起请求,结果显而易见肯定是超时,因为目标节点已经不存在了。为了避免这种情况出现,引入一个新的概念就是健康检查,定期检查该服务节点是否有效,如果失效了及时通知客户端去删除该节点。

etcd健康检查通过租约的方式实现。 用户可以在etcd中注册服务,并且对注册的服务设置key TTL,定时保持服务的心跳以达到监控健康状态的效果。需要维护一个TTL(V3 使用 lease实现),类似于心跳。申请lease租约,设置服务生存周期TTL,让key支持自动过期,在服务正常的状态下,通过KeepAlive定期去续租,避免过期。

通过Grant创建一个租约,并且设置过期时间为9s,在put的时候设置该租约。使用goroutine去定期续租,租约过期时间是9s,那么KeepAlive平均会3s执行一次,这里还需要考虑一个异常场景,ka为nil,极有可能在Keepalive时Lease已经过期,所以需要进行容错处理,分配新的Lease进行重试,这种可能是因为网络原因导致的丢包,续租失败,所以重新执行put就可以。

实现如下:

1 | // 注册服务到etcd |

5.3、总结

在rpc框架中,服务发现与注册非常重要。这里使用gRPC+etcd实现了一个demo。Etcd是Kubernetes集群中的一个十分重要的组件,用于保存集群所有的网络配置和对象的状态信息.很多公司在生产环境中都在使用Etcd,如果微服务技术栈都是使用go,很推荐etcd作为基础组件。